Ollama – KI-Sprachmodelle direkt lokal ausführen

Mit dem Programm „Ollama“ könnt ihr große Sprachmodelle mit wenigen klicks direkt auf eurem Computer lokal ausführen. Somit könnt ihr die KI auch nutzen wenn mal kein Internet zur Verfügung steht und ihr auch nicht sämtliche datenschutzrechtlich problematische Daten an einen unbekannten KI-Server senden möchtet.

Ollama ist ein kostenloses Open-Source-Tool das euch eine grafische Chat-Oberfläche wie ChatGPT bietet und viele verschiedene lokalen Sprachmodelle auszuführen. Nach der Installation müsst ihr lediglich einmalig eure Wunsch-LLM’s downloaden, danach könnt ihr diese dauerhaft ohne Internetverbindung nutzen.

Zur Auswahl stehen verschiedene vortrainierte Modelle wie z.b. „gpt-oss:20b“, „gpt-oss:120b“, „deepseek-r1:8b“ sowie verschiedene „gemma“ als auch „qwen“ LLMs. Das Programm „Ollama“ steht sowohl für Windows-PC’s, als auch Mac sowie Linux-Computer zum Download auf der offiziellen Homepage bereit.

Info: Für die meisten lokalen Sprachmodelle solltet ihr mindestens über 16 GB Arbeitsspeicher oder besser eine Grafikkarte mit mindestens 16 GB Videospeicher besitzen.

So einfach lässt sich Ollama nutzen

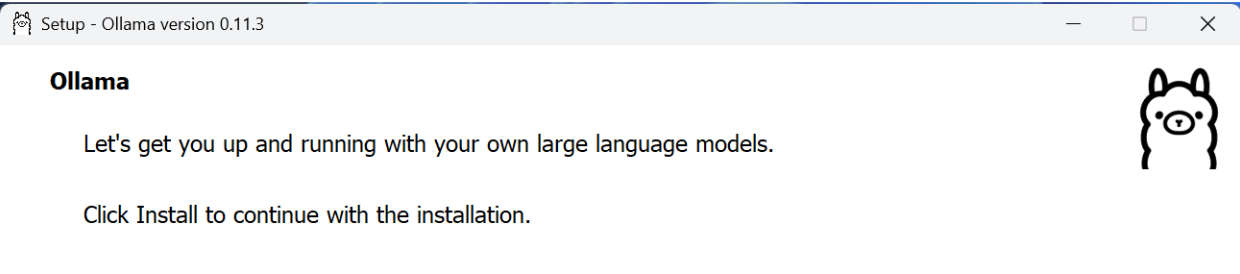

Nachdem ihr das Programm von der offiziellen Webseite heruntergeladen habt, müsst ihr dieses selbstverständlich noch installieren. Nachfolgend zeigen wir euch die Installation auf einem Windows-Computer, auf anderen Systemen kann sich der Ablauf etwas unterscheiden.

Unter Windows klickt ihr die heruntergeladene .exe Datei an um den Installationsprozess zu starten. Im ersten Schritt klickt ihr auf den „Install“ Button, damit die Installation auf eurem Standard-Laufwerk startet – dieser Vorgang kann ein paar Minuten dauern.

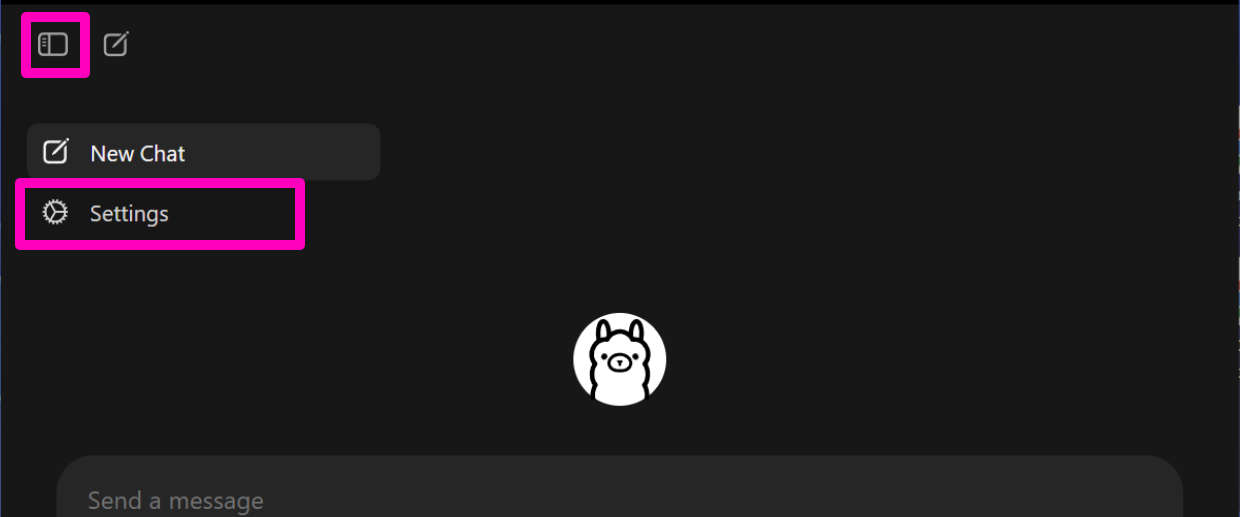

Nachdem dies abgeschlossen ist finden wir uns in der Ollama-Oberfläche wieder, dieses ist ähnlich wie sonstige KI-Chatbots gestaltet, doch bevor wir eine Abfrage absenden, sollten wir zunächst noch den Speicherort unserer KI-Sprachmodelle festlegen, dazu klicken wir auf das obere linke Icon um die Seitenleiste zu öffnen.

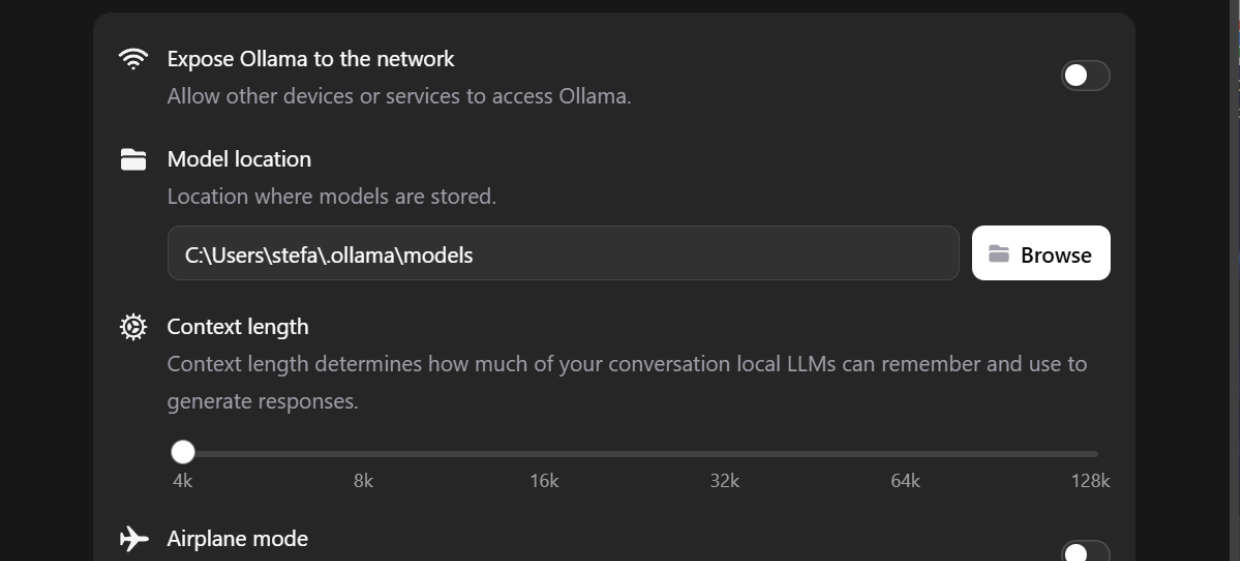

In der Seitenleiste klicken wir jetzt auf „Settings“ um die Einstellungen von Ollama zu öffnen, dort können wir unter anderem dann festlegen ob andere Geräte auf Ollama zugreifen dürfen, wo der Speicherort für die KI-Modelle sein darf, sowie die maximale Context-Länge unseres Chatverlaufs angeben.

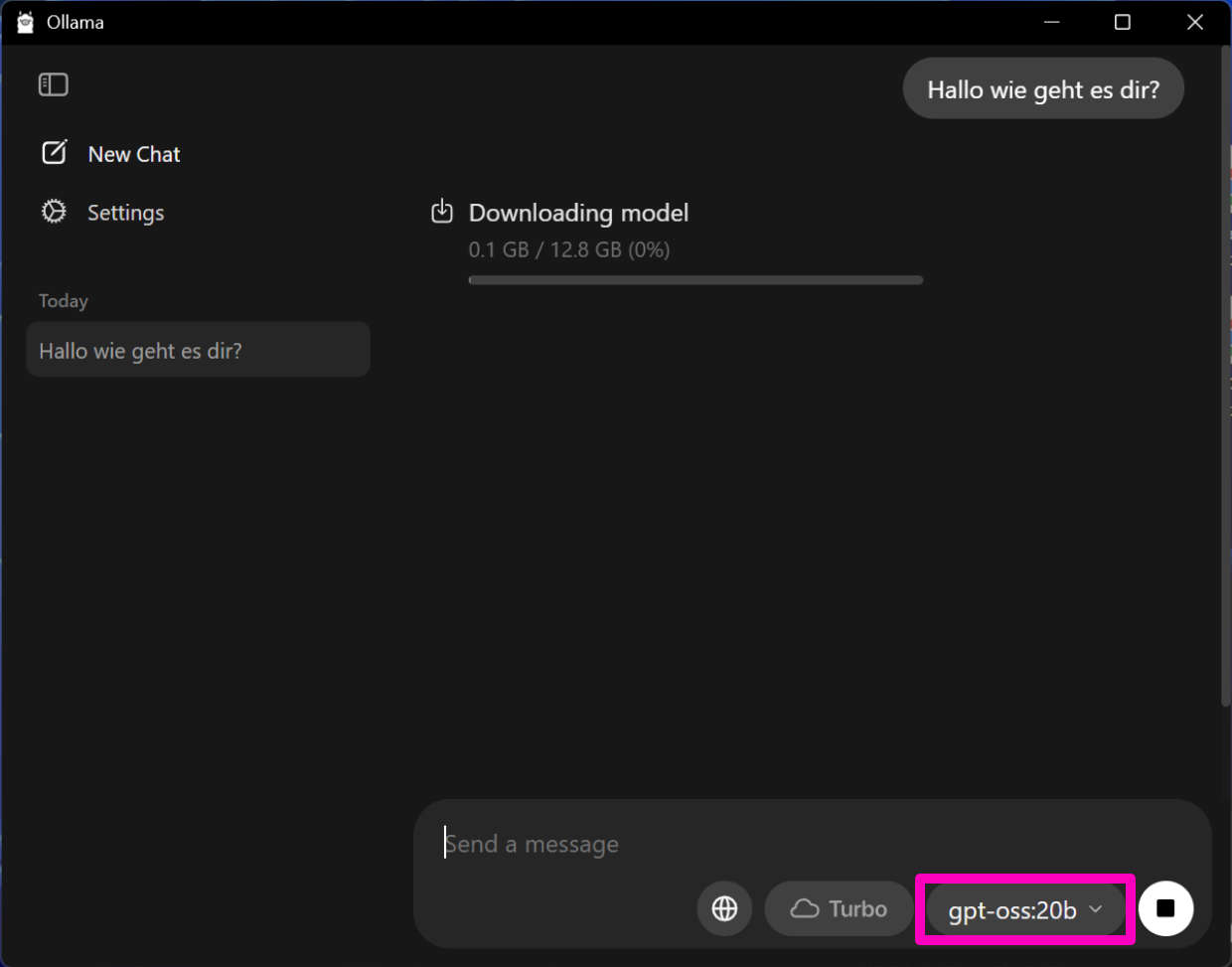

Sobald wir das erledigt haben können wir mit dem oberen linken Pfeil wieder das Einstellungsmenü verlassen und im Chatfenster unser Wunsch-LLM auswählen. Für normale Gaming-Computer könnt ihr dort etwa „gpt-oss:20b“ oder auch „deepseek-r1:8b“ auswählen.

Um den eigentlichen Download des jeweiligen Modells zu starten, schreibt nun eure erste Chatanfrage in das Textfeld. Danach startet der Downloadvorgang – je nach Modell können dies einige Gigabyte sein, weshalb dieser Vorgang einige Zeit dauern kann.

Nach dem abgeschlossenen Download wird das ausgewählte Sprachmodell nun automatisch die erste gestellte Anfrage beantworten. Zukünftig könnt ihr nun sämtliche Anfragen ohne weitere Downloads in das Ollama-Chatfenster eingeben – erst falls ihr das KI-Modell wechselt, benötigt das Programm wieder eine Internetverbindung für den neuen Modell-Download.